am 22.11.2023 - 09:23 Uhr

Die jüngste Vergangenheit hat gezeigt, dass selbst etablierte Cloud-Anbieter mit den technischen Herausforderungen eines hochverfügbaren Rechenzentrumsbetriebs zu kämpfen haben: Von OS-Updates bis zu Sicherheitslücken und Ausfällen von Hardwarekomponenten. Ausfälle scheinen zum Tagesgeschäft zu gehören und sollten somit Inhalt jeder Risiko-Analyse und Konzeption der Infrastruktur und Architektur sein.

Die Frage ist, wie gut Unternehmen auf solche Situationen vorbereitet sind und wie effektiv sie darauf reagieren können. Hier zählt das ganzheitliche Zusammenspiel von Betriebsprozessen und hochverfügbarer Infrastruktur.

MEHR WISSEN GEWÜNSCHT?

Am Dienstag, 21. November 2023, veranstalteten die Unternehmen ICONAG-Leittechnik, B-Unity und die Infrontec Ingenieurgesellschaft das Online-Seminar „Monitoring als Grundlage für Hochverfügbarkeit und Energie-Effizienz von Rechenzentren“.

Im Zeitraum von 13:30 Uhr bis 17:30 Uhr wurden folgende Themen in diversen Vorträgen behandelt:

Die Referenten verfügen über Expertenwissen und umfangreiche Erfahrung aufgrund ihrer verantwortlichen Funktionen, beispielsweise in einem Rechenzentrum einer deutschen Großstadt, bei der Deutschen Flugsicherung sowie in der Planung, Beratung und Umsetzung des Infrastrukturmanagements von Rechenzentren. Die Teilnahme ist kostenlos.

Häufig gibt es noch ein klassisches Silo-Problem. Die IT-Infrastruktur liegt im Verantwortungsbereich der IT, während die Versorgungsinfrastruktur des Rechenzentrums eine Domäne des Facility Managements ist und nicht selten eine sehr unterschiedliche Wahrnehmung der Anforderungen existiert. Einschlägige Statistiken der Branchenverbände zeigen deutlich, dass die Datacenter-Versorgungsinfrastruktur die primäre Ursache für rechenzentrumsausfälle ist. Sie liegt bei mehr als 50 Prozent.

Auch kritische Infrastrukturen benötigen Rechenzentren und IT für die Absicherung der Geschäfts- und Versorgungsprozesse. Insbesondere im übergeordneten gesellschaftlichen Kontext ist der Ausfall von KRITIS-Unternehmen und Einrichtungen ein besonderes Risiko. Der BSI-Grundschutz bildet den regulatorischen Rahmen für den Betrieb dieser KRITIS-Einrichtungen und stellt dafür Anforderungen an die Hochverfügbarkeit und damit auch an das Monitoring von KRITIS-Infrastruktur und Rechenzentren.

Hier ein Auszug aus §8a Abs 1 des BSIG (Bundesamt für Sicherheit in der Informationstechnik): „Betreiber kritischer Infrastrukturen sind verpflichtet … angemessene organisatorische und technische Vorkehrungen zur Vermeidung von Störungen der Verfügbarkeit, Integrität, Authentizität und Vertraulichkeit ihrer informationstechnischen Systeme, Komponenten oder Prozesse zu treffen, die für die Funktionsfähigkeit der von ihnen betriebenen kritischen Infrastrukturen maßgeblich sind. … „

Die Stromversorgung/Elektrotechnik stellt technisch bedingt das zeitkritischste und qualitativ sensibelste Versorgungsmedium dar. Die Toleranzzeit der IT-Schaltnetzteile liegt hier häufig im Bereich bis 20 Millisekunden (ms). Die Kühlung der IT ist, abgesehen von Hochleistungswasserkühlsystemen, durch Speicherkapazitäten des Kühlmediums im Bereich von Sekunden bis Minuten störungstolerant.

Die EN50160 beschreibt als Norm die Anforderungen an die Spannungsqualität im Niederspannungsnetz. Bereits kleine Abweichungen vom Normbereich können Schaltnetzteile und Hardware zum Ausfall bringen.

Die Anforderungen an die so genannten Umgebungsbedingungen im Rechenzentrum sind in der EN50600-2-3 mit Verweis auf die ASHRAE TC9.9 definiert. Entgegen der hohen Sensibilität der Stromversorgung führen klimatische Schwankungen − auch mögliche Grenzwertüberschreitungen der Temperatur und Luftfeuchtigkeit − nicht mittelbar zum Ausfall der IT-Systeme. Zumal diese Parameteränderungen meist im Sekundenbereich stattfinden.

Die Versorgungsinfrastruktur basiert zum großen Teil auf der Infrastruktur der technischen Gebäudeausrüstung (TGA), die zum Teil zwar in höherer Qualität im Datacenter-Umfeld zum Einsatz kommt, jedoch meist keine Spezialtechnik ist. Es handelt sich um mechanische Anlagen, die Wind und Wetter ausgesetzt sind und einem natürlichen Verschleiß unterliegen.

Dagegen wird die IT-Hardware als eher gering verschleißende Komponente unter optimierten Umgebungsparametern betrieben. Redundanzen und Ausfallsicherheit sind in der Serverwelt Designgrundlage. Die Logikebene ergänzt die Ausfallsicherheit auf der OS- oder Applikationsebene. Weiterhin werden Server technologie-, performance- oder -effizienz-/skalierungsbedingt nach wenigen Jahren ersetzt und ein alters- oder verschleißbedingter Ausfall ist selten Ursache von Hardwarestörungen.

IT ist in der logischen und softwarebasierten Welt einfacher und flexibler zu handeln. Meist sind Parameter die Stellschrauben, die Vernetzungen zwischen den Systemen beeinflussen, während in der Versorgungsinfrastruktur Rohrleistungen und Kabel im Störfall nicht ohne Weiteres umparametriert oder abgeschottet werden können. So kann eine kleine Leckage in einem ungünstigen Rohrnetz zum Ausfall führen, wenn dieses nicht die Möglichkeit der Absperrung ohne Versorgungseinbußen bietet. Ebenso wären parallele Leistungsschalter in der Elektrotechnik im Sinne der Redundanz ein klarer Zielkonflikt zwischen VDE und Verfügbarkeit.

Die Versorgunginfrastruktur ist im Vergleich zur IT statischer und muss Ausfallsicherheit bereits konzeptionell beim Aufbau der Infrastruktur bereithalten.

Auch kritische Infrastrukturen benötigen Rechenzentren und IT für die Absicherung der Geschäfts- und Versorgungsprozesse. Insbesondere im übergeordneten gesellschaftlichen Kontext ist der Ausfall von KRITIS-Unternehmen und Einrichtungen ein besonderes Risiko. Der BSI-Grundschutz bildet den regulatorischen Rahmen für den Betrieb dieser KRITIS-Einrichtungen und stellt dafür Anforderungen an die Hochverfügbarkeit und damit auch an das Monitoring von KRITIS-Infrastruktur und Rechenzentren.

Hier ein Auszug aus §8a Abs 1 des BSIG (Bundesamt für Sicherheit in der Informationstechnik): „Betreiber kritischer Infrastrukturen sind verpflichtet … angemessene organisatorische und technische Vorkehrungen zur Vermeidung von Störungen der Verfügbarkeit, Integrität, Authentizität und Vertraulichkeit ihrer informationstechnischen Systeme, Komponenten oder Prozesse zu treffen, die für die Funktionsfähigkeit der von ihnen betriebenen kritischen Infrastrukturen maßgeblich sind. … „

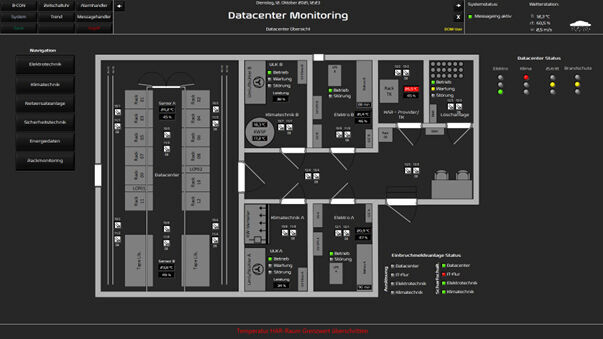

Der Serverraum auf dem Bildschirm.

Der Serverraum auf dem Bildschirm.

(Bild: Iconag Leittechnik GmbH)

Die EU-Direktiven NIS2 (Network and Information Security) und CER (Critical Entities Resilience), welche bis Oktober 2024 durch deutsches Gesetz in Gültigkeit und Umsetzung überführt werden, zielen auf die Verfügbarkeit und Resilienz der Infrastrukturen wie ein Rechenzentrum. Aber auch das EnEfG (Energie-Effizienzgesetz) oder der Gebäude-Energiegesetz (GEG) fordern Monitoring im Rechenzentrum als Lösung zur Energiedatenerfassung und des Energie-Managements.

Dabei hat die DIN EN 50600 noch Potenzial. Die Datacenter Norm enthält nach aktuellem Stand wenige Aussagen, wie ein Monitoring zu realisieren ist. Die EN 50600-2-3 benennt hier nur Schwellwerte und verweist darauf, dass Zulufttemperaturen zu überwachen sind. Besonders in Hinblick auf die Umsetzung des EnEfG und der KRITIS-Anforderungen bleibt zu erwarten, dass die Norm diese Lücke schließen wird.

Ein durchgängiges Hochverfügbarkeitskonzept der Rechenzentrum-Infrastruktur auf physischer und logischer Ebene kann Ausfälle durch Redundanz und Autonomie in den meisten Fällen verhindern. Ein Monitoring erkennt nicht nur Störungen und Abweichungen vom Sollzustand, es bietet je nach Integration auch die Möglichkeit, frühzeitig Störungsentwicklungen zu erkennen und vor deren Eintritt einen Handlungsbedarf abzuleiten. So können intermittierende Fehler oder Betriebs- und Arbeitspunkte von Anlagen in Grenzbereichen Vorboten für Ausfälle sein.

Ein effektives Monitoring verschafft den Beteiligten des Rechenzentrumsbtriebs eine ausreichende Transparenz. Mit einem ausgeprägten Event- und Alarm-Management fügt sich das Monitoring lückenlos in den Datacenter-Betrieb und bietet als Tool den Mehrwert der effizienten und schnellen Lagebewertung und Entstörung von Fehlern sowie der Nachvollziehbarkeit durch Logging und Mess-/Trenddatenaufzeichnung.

Zudem ist das Monitoring eine Form der Dokumentation, die das Rechenzentrum in Form eines „Digital Twin“ abbildet. Auch die Energiedatenerfassung rund um die Infrastruktur ist Teil des Monitorings und wird folgend auch durch das EnEfG gefordert.

Mit wachsender Infrastrukturkomplexität und hybriden Architekturen steigen die Anforderungen auf der Technikseite. Gleichsam sehen sich IT-Abteilungen dem Fachkräftemangel ausgesetzt und müssen neben den Tagesthemen neue Richtlinien der Security und Compliance umsetzen oder den Rückstau an Digitalisierungsprojekten aufholen.

Dies führt häufig dazu, dass die Erweiterung und Pflege des Monitoring vernachlässigt wird. Sobald jedoch ein Monitoring auf Grund der fehlenden Pflege nicht mehr aktuell ist oder gar falsche Meldungen/Zustände visualisiert oder meldet, sinkt die Akzeptanz und der Nutzwert des Systems.

Digitale Zwillinge spielen auch im Datacenter Monitoring zunehmend eine bedeutsame Rolle.

Digitale Zwillinge spielen auch im Datacenter Monitoring zunehmend eine bedeutsame Rolle.

(Bild: ICONAG-Leittechnik GmbH)

Auf Ebene der Infrastruktur findet man herkunftsbedingt gegenüber der IT leider einen bunten Strauß an Protokollen, welche die Integration der TGA-Anlagen in das Monitoring anbieten. Während sich in der IT SNMP, IPMI und REST-APIs als dem Admin bekannte Standards etabliert haben, finden wir in der TGA-Welt Protokolle wie BACnet, Modbus, KNX, M-Bus, Profibus und einige weitere vor.

Immer seltener sind proprietäre Schnittstellen und Protokolle von Herstellern, die bei einem ganzheitlichen und lückenlosen Monitoring ebenso integriert werden müssen. Die Aufgabe des Systemintegrators aus dem Bereich der Gebäude-Automation ist es, diese Protokolle direkt oder über Gateways an das Monitoring-System anzubinden.

Unter diesen Voraussetzungen ist die Auswahl des richtigen Monitoring-Tools entscheidend. Offene Systeme und Schnittstellenkonzepte haben sich als flexibel und nachhaltig erwiesen.

Ein besonderes Augenmerk der Integration sollte bei der IT-Security liegen. Ein Teil der Schnittstellen bietet historisch und designbedingt keine IT-Sicherheit und kann unsicher eingesetzt die Verfügbarkeit durch ein Sabotagepotenzial mindern. Zunehmend finden hier auch sichere Protokolle und Schnittstellen wie BACnet/SC, KNX Secure, OPC UA und MQTT Einzug. (Zu diesem Thema hat Christian Wild, Geschäftsführer des Partners ICONAG-Leittechnik in Idar-Oberstein, bereits einen Artikel verfasst: „ Recht und gesunder Sachverstand IT-Sicherheit und Verfügbarkeit in der Gebäude-Automation bei Rechenzentren“).

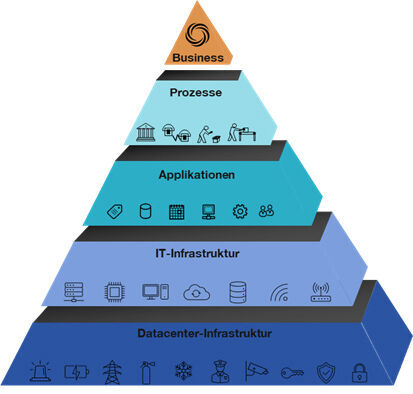

Im Sinne des abgesicherten Geschäftsprozesses erstreckt sich ein Monitoring nicht nur auf die Versorgungsinfrastruktur. Jeweils die höhere Ebene ist von der darunterliegenden Ebene abhängig. So steht der Geschäftsprozesses in Abhängigkeit dieses „Stacks“ von Infrastruktur, Hardware, Software und Prozessen.

Monitoring sollte die Abhängigkeiten von Versorgungsinfrastruktur, Hardware, Software und Prozessen mit ein.

(Bild: ICONAG-Leittechnik GmbH)

Da jede Ebene eine eigene technische Disziplin ist, findet man am Markt meist Lösungen, welche in einer oder maximal zwei dieser Ebenen als Monitoring-Tool eingesetzt werden können. Ein Tool zu finden, das alle Bereiche gleichermaßen abdeckt, wird bei den individuell ausgeprägten Infrastrukturen kaum möglich sein. So finden sich hier erfahrungsgemäß mehrere Tools wieder, deren Spezialisierungsschwerpunkt in einer, maximal zwei dieser Ebenen liegt.

Je nach Hierarchie-Ebene gibt es spezialisierte Monitoring-Tools. Die Herausforderung besteht darin, relevante Informationen für verschiedene Nutzergruppen bereitzustellen.

Während Techniker detaillierte Einblicke benötigen, setzen Manager auf Dashboards und KPIs. Im Sinne einer rollenbasierenden Informationsbereitstellung eigenen sich daher Dashboard-Anwendungen, die Daten aus den Monitoring-Systemen der Ebenen aufnehmen und im Kontext der Absicherungen eines Geschäftsprozesses als Ampel darstellen können.

Betrachtet man im Rahmen des Risiko-Managements die Kosten eines IT-Ausfalls, die durch den zunehmenden Digitalisierungsgrad in Unternehmen immer weiter steigen, so gilt es, geeignete Maßnahmen zur Risikokontrolle und Verfügbarkeitssicherung zu etablieren. Die Aufwände zur Integration eines Monitoring-Tools teilen sich bei kommerziellen und 'supporteten' Lösungen in Lizenzierungskosten und Systemintegration.

Die Lizenzkosten setzen sich hier marktüblich zusammen aus einem Grundpreis für die Software und für die Module für Features und Schnittstellen, der sich aus der Anzahl der Datenpunkte/Metriken ergibt die zu überwachen sind. Ebenso findet man Abo-Modelle, die je nach aktuellem Bedarf frei skalierbar über eine monatliche/jährliche Nutzungsgebühr abgerechnet werden.

Monitoring dient zudem als Grundbaustein für die Automatisierung, indem es sensorische Eingangsdaten für Soll-Ist-Vergleiche liefert. Ob im Bereich Datacenter oder IT-Infrastruktur − Automatismen werden durch gemessene Daten und Ereignisse ausgelöst. Die proaktive Nutzung von Ressourcen basiert hier auf historischen Trenddaten.

![]()

Von Matthias Braun

Bildquelle: b-unity GmbH

Über den Autor

Sebastian Mitscherlich ist Consultant Automation und Datacenter bei der B-Unity GmbH in Breuberg.

Das junge IT-Beratungshaus ist spezialisiert auf Application Lifecycle Management und die Infrastruktur von Rechenzentren. Es bietet seinen Kunden Beratung für den IT-Betrieb. Im Bereich Datacenter unterstützt B-Unity seine Kunden bei der Planung, Konzeption, dem Betrieb und der Optimierung von Rechenzentren gemäß den technischen und prozessualen Anforderungen der EN50600. Eines der Schwerpunktthema ist Datacenter Monitoring mitsamt Systemintegration, IT-Sicherheit sowie den Aufbau von Management- und Bedieneinrichtungen.

Er sagt: „Effizientes Monitoring ist unerlässlich für hochverfügbare und komplexe IT-Landschaften. Es ermöglicht nicht nur die Vermeidung von Ausfällen, sondern auch die Optimierung von Betriebsprozessen. Die individuellen Anforderungen eines Unternehmens sollten bei der Auswahl und Implementierung eines Monitoring-Systems berücksichtigt werden. Der langfristige Erfolg liegt neben der Einführung auch im kontinuierlichen Betrieb und der regelmäßigen Anpassung des Monitoring-Systems.“

Powered by ModuleStudio 1.3.2